Suchmaschinenoptimierung – englisch: Search Engine Optimization (SEO)

bezeichnet Maßnahmen, die dazu dienen, die Sichtbarkeit einer Website und ihrer Inhalte für Benutzer einer Websuchmaschine zu erhöhen. (Quelle: https://de.wikipedia.org/wiki/Suchmaschinenoptimierung)

von Daniel Dorfer

Auf der Suche nach SEO

„Die beste Art eine Leiche zu entsorgen ist sie auf Seite zwei bei den Google Suchergebnissen abzulegen.“ (Autor unbekannt)

In diesem frei aus dem englischen übersetzten Zitat liegt viel Wahrheit, denn bereits ab Position fünf auf der ersten Seite der Google Suche wird man nachweislich nicht mehr richtig wahrgenommen, geschweige denn angeklickt. Da muss jemand schon sehr verzweifelt nach etwas suchen, wenn er auf die hinteren Seiten der Suchergebnisse klickt.

Mit über 94% Marktanteil ist Google die meistgenutzte Suchmaschine in Deutschland. Und da die meisten Blogger den Großteil ihrer Leserschaft aus genau dieser Quelle generieren, lohnt es sich durchaus, sich etwas mehr mit dem Thema Suchmaschinenoptimierung, kurz SEO (Search Engine Optimization), zu beschäftigen.

Fundiertes Know-How in dieser schnelllebigen Branche vermitteln unter anderem Lehrgänge, wie etwa der Onlinekurs zum SEO Professional bei den Online-Marketing Profis von 121watt.de. Selbst wenn man glaubt ein wenig Ahnung von der Materie zu haben, lernt man dabei mit Sicherheit eine Menge Neues dazu.

Wer genau wissen will was SEO ist und wie es funktioniert findet hier! die fundierte Antwort von SEO-Profi Alexander Holl. In diesem Beitrag erfährt man neben der Funktionsweise einer Suchmaschine unter anderem auch, warum SEO in der heutigen Zeit so wichtig ist und was es unterm Strich bringt.

Viele Journalisten und Blogger vernachlässigen diesen elementaren Baustein im Online-Marketing und schreiben so, wie sie es vor vielen Jahren einmal gelernt haben. Doch das läuft leider nicht mehr. Entsprechend gering fallen meist die Zugriffszahlen aus und die Besucherzahlen stagnieren trotz einiger eigentlich interessanter und hilfreicher Beiträge.

Wer gut gefunden werden will, muss sich im Zeitalter des Internets an einige elementare Grundsätze und Regeln halten.

Google Core Update 2021

Die beiden großen Google Core Updates im Juni und Juli 2021 haben den Suchmaschinen-Algorithmus erneut ziemlich durcheinander gewürfelt. Für viele Blogs und Webseiten ging es in den Suchmaschinenergebnissen (SERP = Search Engine Result Page) ganz drastisch bergab. Diese beiden Änderungen haben insbesondere der gesamten Reisebranche hart zugesetzt, denn wegen der Auswirkungen von Corona nahm die Relevanz des Themas Reisen sehr stark ab. Gewinner dieser Änderungen waren etwa Seiten mit medizinischen Inhalten, reine Onlineangebote und Onlineshops.

https://blog.searchmetrics.com/de/google-core-update-juni-juli-2021/

Doch auch hier kommen sicher wieder andere Zeiten und darauf sollte man im digitalen Zeitalter gut vorbereitet sein. Deshalb gibt es in diesem Beitrag die im Jahr 2021 wichtigsten Faktoren für eine erfolgreiche, möglichst suchmaschinenkonforme Webseite.

Das Thema ist mittlerweile sehr viel komplexer als noch vor 15 Jahren und eine Wissenschaft für sich. Da Google seine Berechnungsgrundlagen aus gutem Grund streng geheim hält, ist es ein ständiges versuchen und interpretieren der kryptischen Aussagen von Verantwortlichen beim Marktführer unter den Suchmaschinen. Einiges weiß man bereits seit Jahren, doch viele wirksame Maßnahmen, die hier beschrieben werden, basieren auf Vermutungen und sind das Ergebnis von Recherche, Analyse, Versuch und Scheitern. Weil Änderungen in Sachen SEO in der Regel nicht umgehend Erfolg oder Misserfolg anzeigen, ist dies ein zeitraubender und langwieriger Vorgang.

Professionelle Suchmaschinenoptimierer, die sich mit der Materie gut auskennen, verdienen viel Geld damit und verraten nur selten ihre Erfolgsgeheimnisse. Doch es gibt auch andere, wie etwa den sehr versierten Blogger Finn Hillebrandt. In seinem Blog findet man alle der mittlerweile mehr als 200 Merkmale und Ranking-Faktoren für den Erfolg bei Google. Hier geht es wirklich ins Detail: https://www.blogmojo.de/google-ranking-faktoren/

Wichtige Tools zur Kontrolle der SEO-Maßnahmen

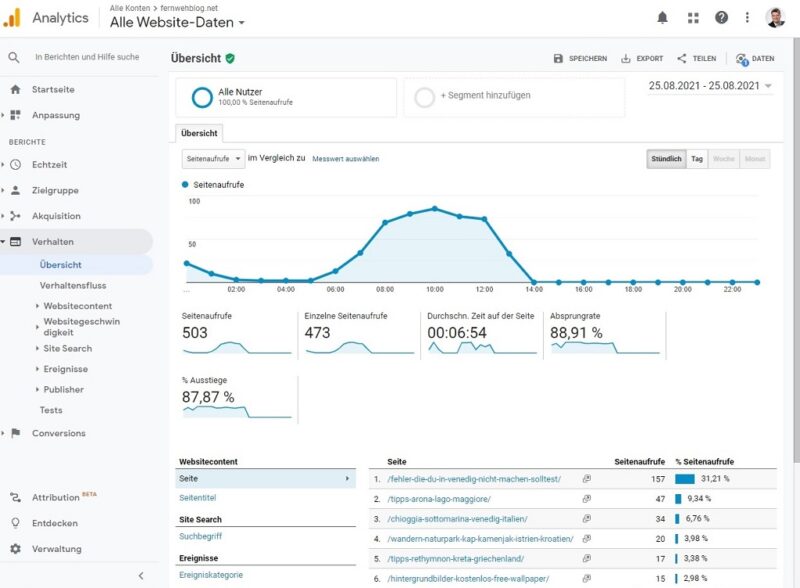

Bei diesen drei kostenlosen Tools von Google sollte man sich vorab unbedingt anmelden um die Daten der Webseite detailliert auswerten zu können. Neben den Besucherzahlen erfährt man auch mehr zum Besucherfluss, der Aufenthaltsdauer und findet Anregungen zur Leistungsverbesserung der eigenen Website.

- Google Analytics https://analytics.google.com/analytics/web/

Den Einbau des dafür notwendigen Tracking-Codes sollte ein Webmaster oder Administrator erledigen der sich ein bisschen damit auskennt. Mit dem dazugehörigen ebenfalls kostenlosen WordPress-Plugin Google Site Kit kann man einige Berichte und Statistiken auch direkt im Dashboard des WordPress-Blogs anzeigen:. Allerdings ist die Auswertung dort bei weitem nicht so detailliert wie auf der Google Analytics Webseite.

Die kostenlose Google Analytics App für das Smartphone ist ebenfalls empfehlenswert. Downloadbar bei

Google Play: https://play.google.com/store/apps/details?id=com.google.android.apps.giant

Apple App Store: https://apps.apple.com/de/app/google-analytics/id881599038

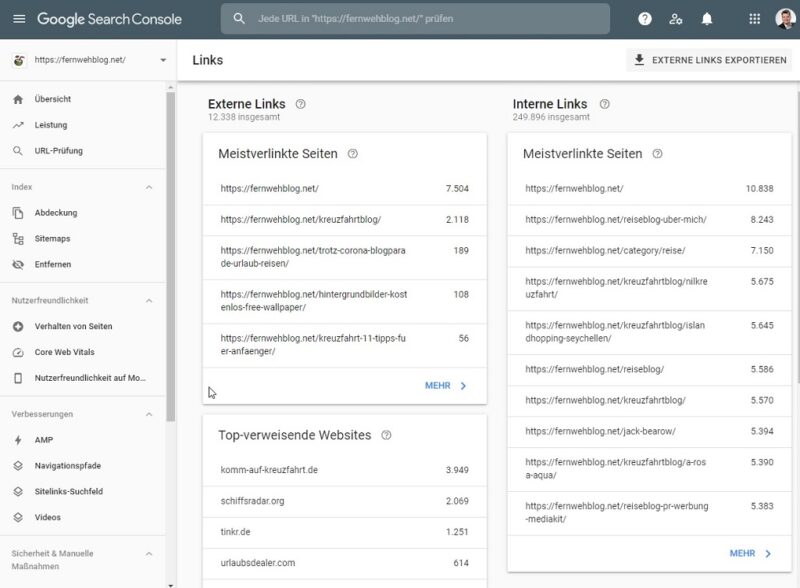

- Google Search Console https://search.google.com/search-console

Hier kann man wirklich detailliert auswerten wie die eigenen Inhalte bei Google performen. Auch bei Problemen mit der Seite in der Suchmaschine ist diese Konsole erste Anlaufstelle.

Unter Manuelle Maßnahmen kann man etwa einsehen ob die Seite gesperrt (Google Penalty) wurde und etwas dagegen tun oder wo generell Crawlingfehler auftauchen. Sollte es größere Probleme beim Erfassen des Contents geben, wird man in der Regel per E-Mail benachrichtigt.

Im Menü für die Links sieht man auch welche Domains auf das eigene Projekt verlinken, leider jedoch nur maximal 1000 Einträge. Alles darüber fällt dann in den professionellen Bereich und verlangt ein kostenpflichtiges Tool alternativer Anbieter.

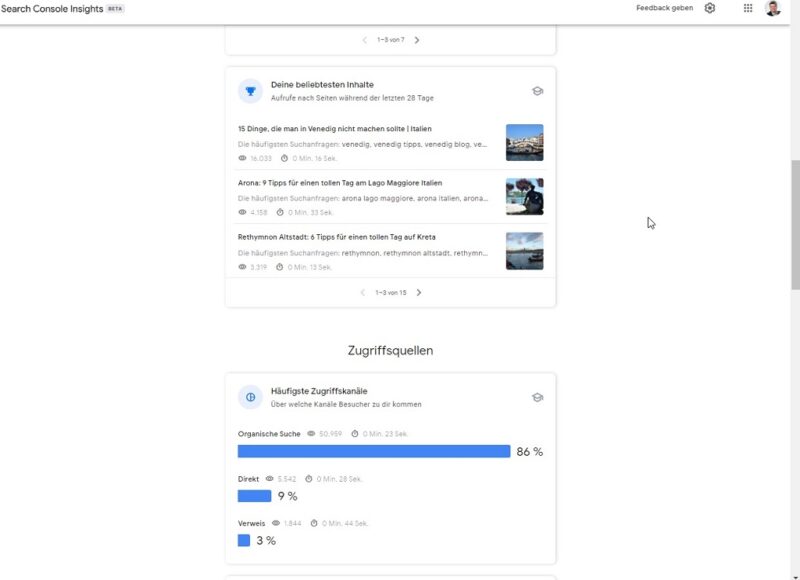

- Brandneu: Google Search Console Insights

https://search.google.com/search-console/insights/

Aus der Verbindung der beiden zuerst genannten Tools entstand Google Search Console Insights. Hier erhält man grafisch ansprechend aufgearbeitet einen ersten Überblick über die wichtigsten Daten rund um die eigenen Seiten in der Google Suche. Diese Seite spielt übrigens den Inhalt schon komplett im mobilen Design aus, auch am PC oder Notebook.

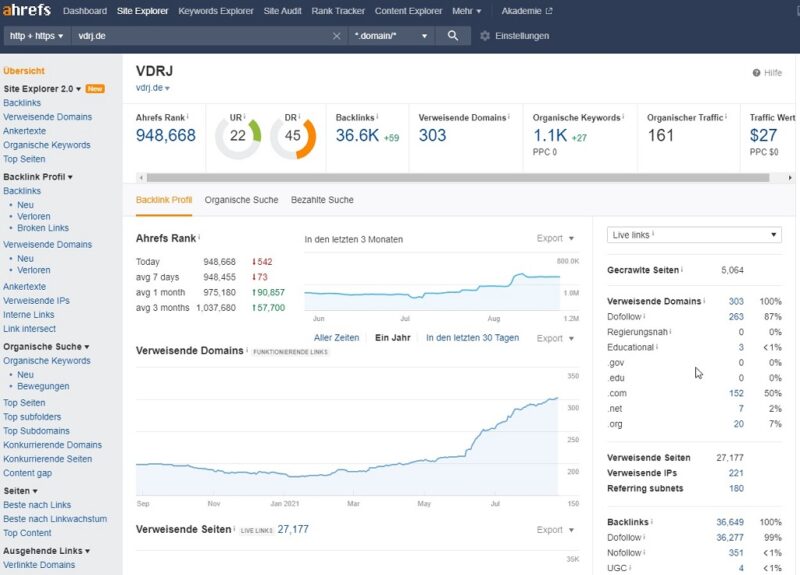

Professionelle und kostenpflichtige SEO-Tools

Professionelle SEO-Tools wie Sistrix, Searchmetrics, ahrefs, XOVI, MOZ oder SEMrush lassen sich ihre Dienste teuer bezahlen und sollten eigentlich nur in Anspruch genommen werden, wenn man sie auch täglich professionell nutzt. Dann ist es wirklich gut investiertes Geld. Dafür bieten diese Tools dann auch wesentlich mehr, liefern etwa konkrete Wettbewerbsanalysen, stellen umfangreiche Keyword-Ideen aus einer riesigen aktuellen Datenbank auch zum Download als Tabelle zur Verfügung und zeigen Möglichkeiten zur besseren Verlinkung auf.

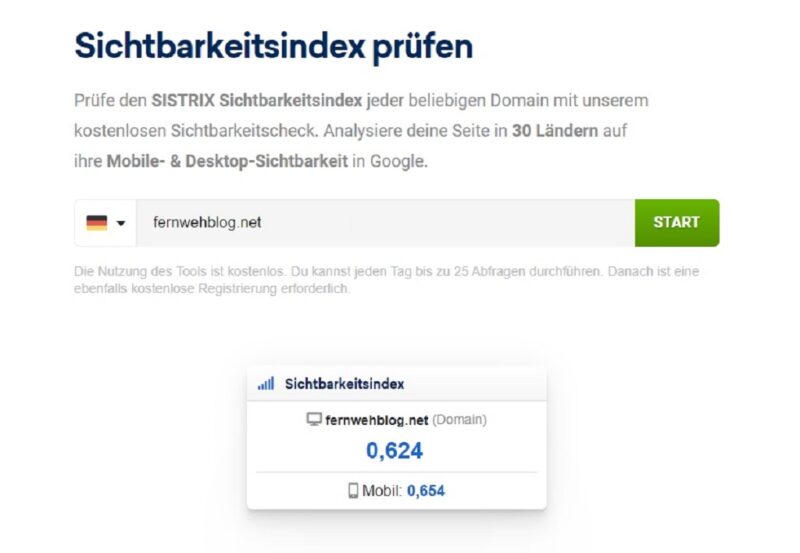

Sichtbarkeit im World Wide Web

Als Grundlage für die Sichtbarkeit einer Webseite im Internet erstellen verschiedene Anbieter wie etwa Sistrix unter Verwendung eigener Algorithmen einen sogenannten Sichtbarkeistsindex. Dieser zeigt an, wie gut eine Seite in Konkurrenz zu ALLEN anderen Seiten im Internet in den Top 100 Suchabfragen der Suchmaschinen vertreten ist. Je mehr wichtige und gefragte Keywords in der organischen Suche auf guten Plätzen angezeigt werden, desto besser ist dieser Wert.

Hier kann man seinen Status Quo in Sachen Sichtbarkeit kostenlos berechnen lassen:

Ohne direkten Vergleich mit der Konkurrenz sagt diese Zahl für den Laien jedoch erst einmal nichts aus. Vergleiche von Kirschen mit Melonen sollte man dabei tunlichst vermeiden. Die Online-Präsenz einer überregionalen Tageszeitung mit all ihren Artikeln ist natürlich wesentlich größer als die eines kleinen Reiseblogs. Außerdem sind da tagtäglich hauptberufliche SEO-Profis am Werk, die für die gute Auffindbarkeit der digitalen Zeitungsartikel sorgen. Wenn man nicht tiefer in diese Materie eintauchen will kann man sich das sparen.

SEO-Grundsatz: Einmaliger Content is King

Natürlich steht qualitativ hochwertiger und einzigartiger Inhalt immer noch ganz oben bei den Rankingfaktoren. Künstliche Intelligenz (KI) ist dabei das Zauberwort der Suchmaschinenbetreiber, denn selbst denkende Computer bewerten die Texte und Bilder im Index auf Relevanz. Anders wäre das bei der tagtäglichen Masse an Inhalten nicht zu bewältigen. Man muss aber dennoch tolle Inhalte für Menschen schreiben und nicht für Maschinen.

„Verfasse einmalige, interessante und gut recherchierte Beiträge, die sich quasi von selbst teilen und halte diese stets möglichst aktuell, dann bist Du auf der sicheren Seite!“

…sagt zumindest Google sinngemäß seit Jahren. Leichter gesagt als getan. Und manchmal reicht das trotzdem nicht um aus der schieren Flut von Artikeln und Beiträgen heraus zu stechen oder es dauert schlichtweg zu lange. Dann auch noch die gute Position zu halten ist die nächste Herausforderung.

Wenn man jedoch von Anfang an ein paar der wichtigsten SEO-Grundlagen beachtet, dann rankt ein Beitrag mit viel Glück ganz von selbst ziemlich schnell ganz weit oben und wird auch fleißig geteilt. Fangen wir an…

Keywordrecherche als Grundlage

Eine fundierte Keywordrecherche sollte bei der erfolgreichen Onpage-Optimierung noch vor den ersten Zeilen des neuen Beitrages stehen. Oft weiß man gar nicht so genau wonach die Nutzer im Internet suchen oder hat selbst einen Suchbegriff im Kopf, der eher selten gesucht wird. Meist gibt es sogar eine komplette Keywordphrase, also ein sogenanntes Long Tail Keyword, welches aus mehreren Begriffen besteht und wesentlich besser zu den veröffentlichten Inhalten passt. Nur selten ist es ein einzelnes Wort, in vielen Fällen sind es sogar verwandte Begriffe und ganze Fragen drumherum, welche die Besucher auf die Seite locken.

Wenn es tatsächlich doch einmal solch ein simples Wort ist, dann hat eine kleine Seite selten die Chance ganz oben mitzuspielen. In solchen Fällen konzentriert man sich lieber auf alternative Suchbegriffe, welche bei weitem nicht so hart umkämpft sind.

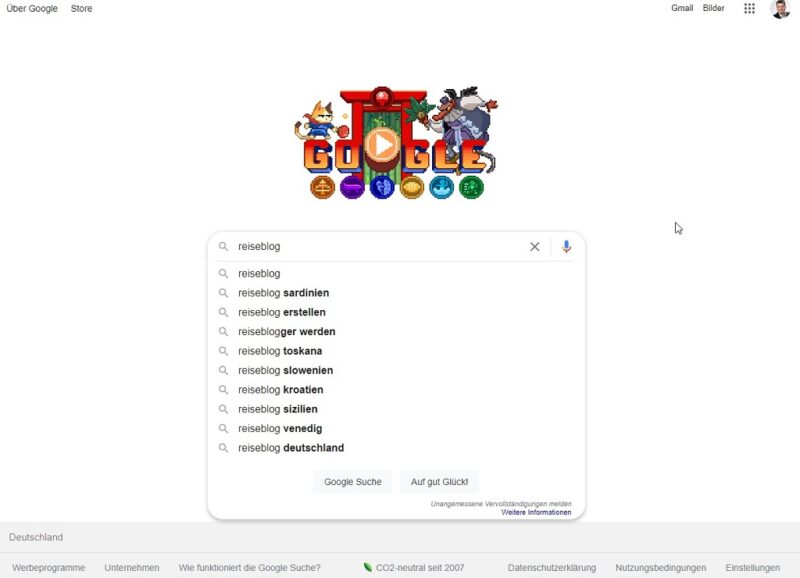

Relevante Keyword-Ideen finden sich zu aller erst mit der eigenen Suche bei Google und den beim Eintippen angezeigten Suchvorschlägen.

Auch die bei der Google Suche ganz unten angezeigte Kategorie verwandte Suchanfragen liefert wichtigen Input für Keyword-Ideen im Beitragsentwurf.

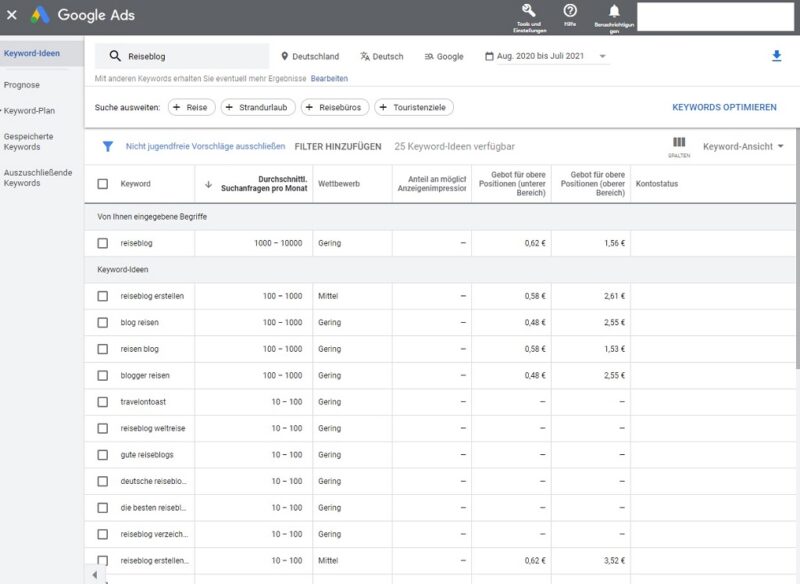

Zusätzliche Inspiration bieten kostenlose Tools wie Google Ads und Google Trends.

Google Ads ist das Portal für bezahlte Werbung in den Google Suchergebnissen, kurz SEA (Search Engine Advertising) genannt. Um dem Werbetreibenden eine Grundlage für die kostenpflichtige Buchung zu bieten werden hier die wichtigsten Daten zur Verfügung gestellt. Im Keywordplanner erhält man nicht nur tolle Ideen für Synonyme und verwandte Suchbegriffe, es wird auch gleich das ungefähre Volumen der Suchanfragen dafür angezeigt. Die Kosten hinter den Keywords geben einen groben Anhaltspunkt wie stark der jeweilige Begriff umkämpft ist.

https://ads.google.com/intl/de_de/home/tools/keyword-planner/

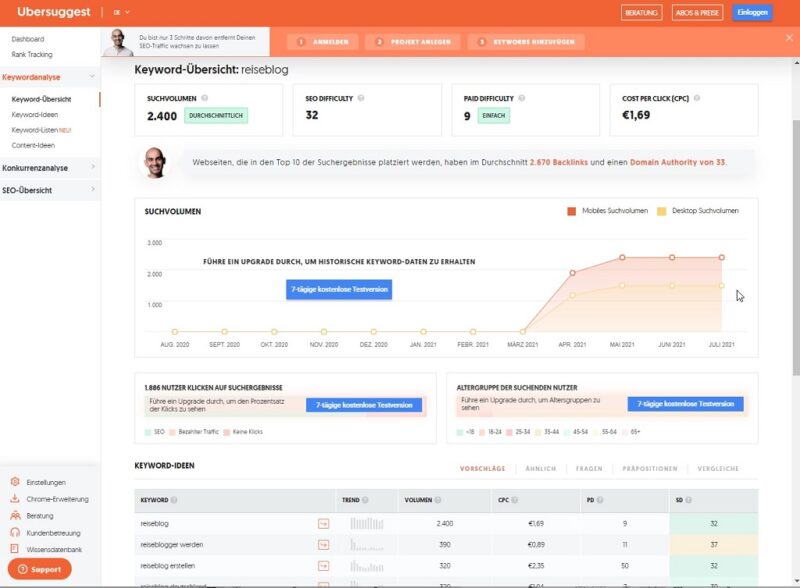

Ein weiteres kostenloses Tool für Keywordvorschläge ist Ubersuggest, welches mittlerweile vom SEO-Tool-Anbieter Neil Patel aufgekauft wurde und als Appetizer für seine Bezahldienste fungiert. Eine täglich limitierte Anfrage von Keywords ist dennoch möglich.

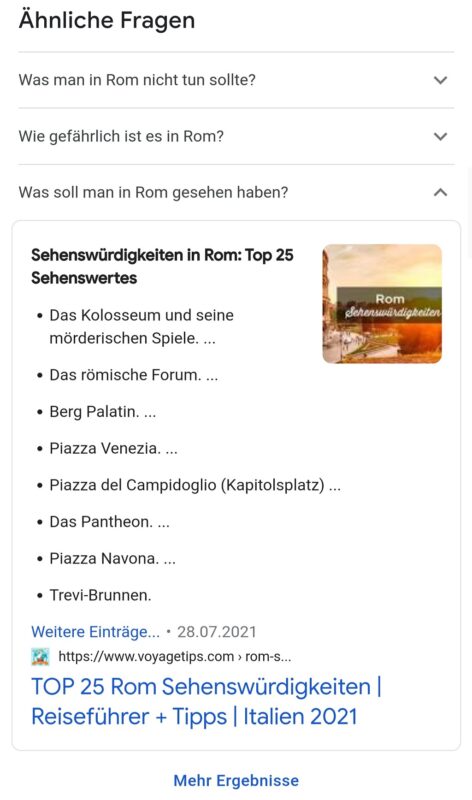

Wichtig sind mittlerweile auch die W-Fragen bei der Suchmaschinenoptimierung. Bereits aktive Vorschläge dafür findet man oft in den Google Suchergebnissen auf Seite 1.

Weitere Ideen liefert das zum Teil kostenlose Tool Answer the public. Bitte vergesst nicht hier die Suche auf Germany und Deutsch einzustellen. Die hier ermittelten Daten lassen sich sowohl als Bild, als auch als Tabelle im .csv-Format downloaden.

Bei eher selten gefragten Keywords wie „Reiseblog“ ist die Auswahl noch überschaubar.

Hingegen ist die Auswahl bei viel gesuchten Begriffen wie „Rom“ gewaltig:

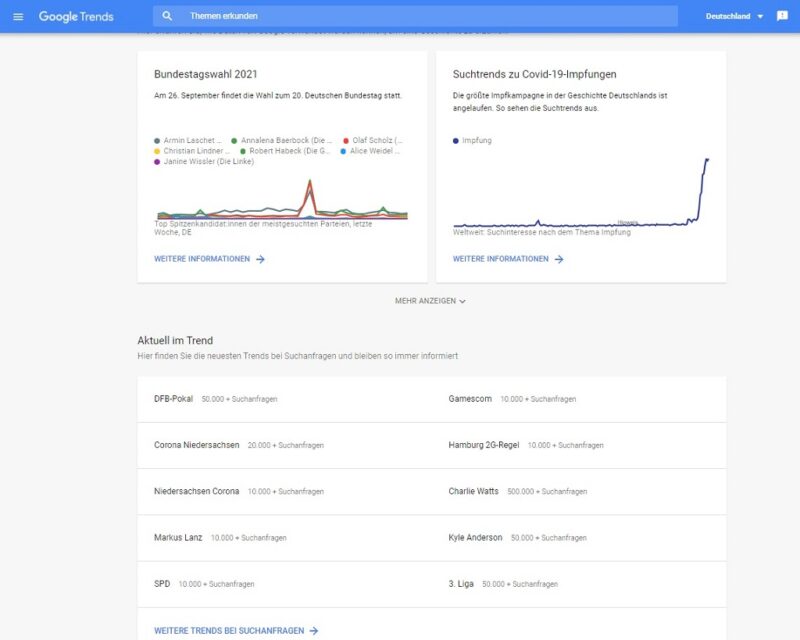

Wer ganz allgemein auf der Suche nach Keyword-Input zu den aktuell gefragten Suchtrends ist, der wird auf Google Trends fündig.

Hier lässt sich Google in die Karten schauen und zeigt regional wo auf der Welt welche Themen gerade sehr oft abgerufen werden.

Mit Hilfe all dieser Tools kann man nun eine Keywordliste aller in den eigenen Augen relevanten Suchbegriffe und Fragen erstellen, um diese dann später an geeigneter Stelle in den Artikel einfließen zu lassen.

Richtig gute Tools zur Keywordrecherche und Wettbewerbsanalyse sind jedoch kostenpflichtig. Ab mindestens 100 Euro pro Monat ist man bei den oben bereits genannten Anbietern wie Sistrix, Searchmetrics oder ahrefs mit von der Partie. Man muss selbst entscheiden ob es einem das wert ist und man es entsprechend nutzt. Wenn es um gezieltes SEO-Writing (Copywriting), also speziell für die Suchmaschinen optimierte Werbetexte geht, sind solche Tools hingegen unabdingbar.

Die sprechende URL

Die zwei bis fünf wichtigsten Keywords, also am besten, die mit den am meisten zu erwartenden Suchanfragen, sollten nun als erstes in den Link zum geplanten Beitrag. Dabei trennt man die Wörter mit einem simplen Bindestrich (kein Unterstrich), damit der Leser auch gleich auf Anhieb erkennt worum es auf der Seite geht. (Stichwort: sprechende URL)

Der Platz hierfür ist jedoch beschränkt, die URL sollte inklusive Domainnamen nicht länger als 75 Zeichen sein, alles dahinter wird in den Suchergebnissen abgeschnitten. Kleinschreibung ist Pflicht und zu viele Unterordner im Pfad sind zu vermeiden, auch wenn WordPress dies früher als Standardeinstellung hatte.

Kryptische Links wie die folgenden fiktiven, aber immer wieder ungern gesehenen Negativbeispiele sind unbedingt zu vermeiden:

- https://meinedomain.de/2020/10/08/reisefuehrer/top-destination-citytrip-teil-21-malta/

- https://test.meinedomain.de/app-listing-details?ProductId=5fc5e7c1072bc33e49248093

- http://www.meinedomain.de/?p=123

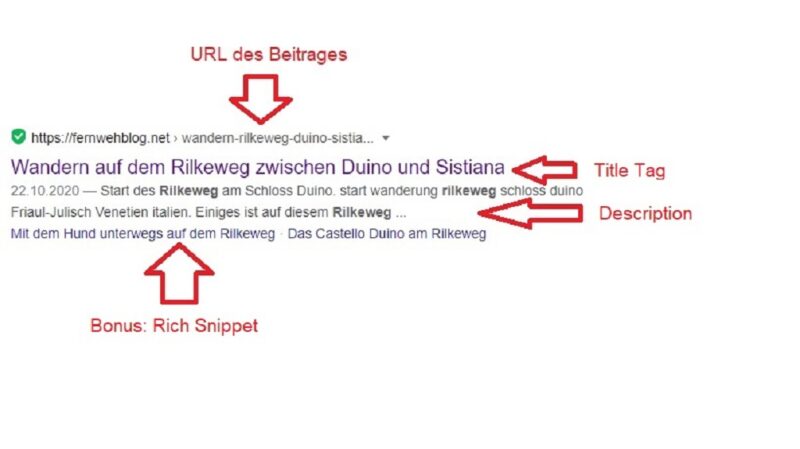

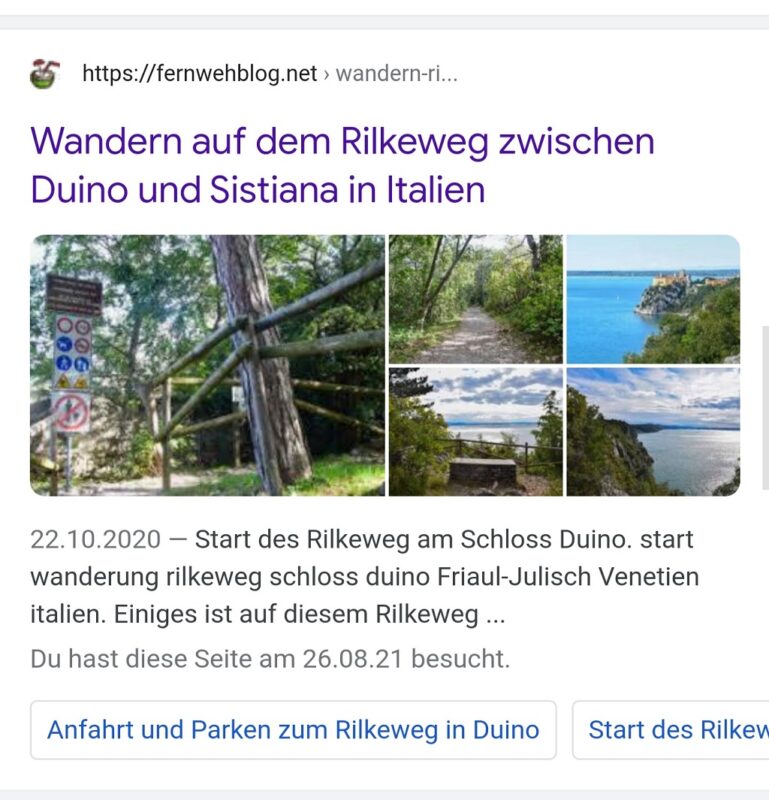

So sieht ein gutes Snippet in der SERP aus, es wurden sogar zwei scheinbar gefragte Sprungmarken aus dem Inhaltsverzeichnis übernommen. In der mobilen Variante sind sogar zahlreiche Bilder mit dabei. Allerdings hat Google hier leider nicht die ursprüngliche Beschreibung verwendet. Es besteht also noch Verbesserungspotential.

Keywords in Title und Description

Neben der URL wertet Google wie man im Bild oben sehen kann auch den Title Tag, also in der Regel die <H1>-Überschrift, sowie die Description, also die Beschreibung der Seite in den Meta Tags aus. Nur eine H1-Überschrift pro Seite oder Blogbeitrag ist hier zu verwenden.

Diese drei Bestandteile sind schon einmal extrem wichtig bei der Suchmaschinenoptimierung, denn sie sind Dein Aushängeschild in den Suchergebnissen. Wenn diese Merkmale ansprechend gestaltet sind, erhöhen sie die sogenannte Click Through Rate (CTR) durch die Besucher, sprich die Zugriffszahlen steigen.

Auch die Anzahl der Zeichen für Title und die Description sind beschränkt, doch es ist leider nicht mehr ganz so klar definiert wie mit der URL. Zwar hat man irgendwann einmal als Anhaltspunkt 60 Zeichen für den Titel und 160 Zeichen für die Beschreibung festgelegt, jedoch hat Google dies aus Platzgründen in Pixel umgerechnet. Da ein W wesentlich mehr Platz einnimmt als ein I ist damit die Berechnung nicht mehr ganz so einfach.

Beim etwas breiter angezeigten Title sind es derzeit 580 Pixel für Desktop und 920 Pixel für Mobile, also etwa 49 bis 60 Zeichen. Bei der kleiner geschriebenen Description darunter 990 Pixel für Desktop beziehungsweise 1.300 Pixel für Mobile. Man empfiehlt allgemein zwischen 100 und 155 Zeichen für die Beschreibung. Hier heißt es also gut überlegen was reinkommen soll. Vor allem sollte die Description zusätzlich noch einen call to action beinhalten, ergo den User zum Klicken animieren. Die beiden weiter unten genannten kostenlosen WordPress-Plugins von Yoast SEO oder Rank Math SEO helfen bei der Einhaltung dieser Vorgaben.

Trotz aller Mühe kann man, wie im Screenshot oben zu sehen ist, nicht hundertprozentig steuern, was Google in das angezeigte Snippet, also in die Beitragsvorschau, aufnimmt. Da kann auch ein ganz anderer Ausschnitt aus dem Text oder der Alt-Tag eines Bildes als wichtiger gewertet werden und bei Bedarf die sorgsam durchdachte Description einfach ersetzen.

Verteilung der Keywords im Inhalt

Relevante Keywords müssen auch unbedingt im ganzen Text verteilt werden, vor allem in den Zwischenüberschriften (H2-H6). Übertreiben sollte man das aber bitte nicht, denn Keywordstuffing, sprich das Überladen des Inhaltes mit Suchbegriffen, mag Google gar nicht. Merksatz auch hier: Wir schreiben immer noch für den Menschen, nicht für die Maschinen. Früher war der Anhaltspunkt einmal 2-3% des Textes sollte die exakten Keywords oder Keywordphrasen beinhalten, doch das ist längst nicht mehr so wichtig. Google erkennt und wertet mittlerweile auch unterschiedliche Wortformen und Synonyme, sowie Wörter die nicht direkt nebeneinanderstehen. Kostenlose WordPress Plugins wie Yoast SEO oder Rank Math SEO helfen hier das richtige Maß zu finden.

Insbesondere die Strukturierung durch Zwischenüberschriften mit dem dazugehörigen Inhaltsverzeichnis (TOC = table of contents) samt Sprungmarkenlinks zu Beginn eines Beitrages sind ein weiterer wichtiger Rankingfaktor. Wenn Google diese für gut befindet tauchen sie sogar in den Rich Snippets auf, was eine auffällige und herausstechende Beitragsvorschau darstellt.

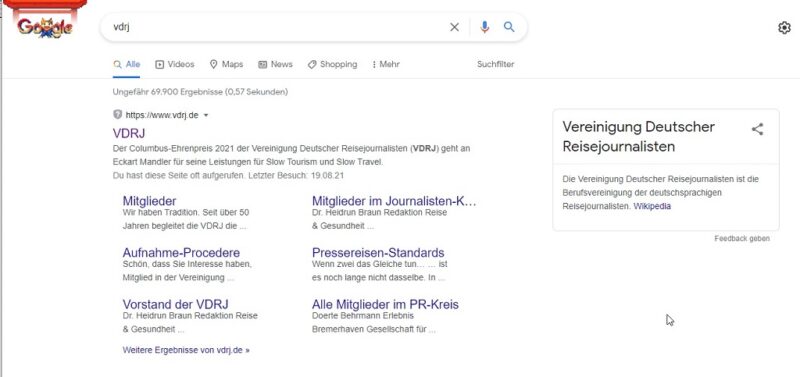

Dieses Rich Snippet der VDRJ im Google Suchergebnis ist mustergültig, sogar der dazugehörige WikiPedia-Eintrag steht direkt daneben. Ein Foto dazu wäre noch die Krönung, doch das passiert aktuell eher selten, meist bei Kochrezepten.

All das gestaltet einen Beitrag in den Augen des Suchenden wesentlich interessanter, denn damit erhält der Link quasi eine Auszeichnung für besonders gut zur Suchanfrage passenden Content. Sogar Links auf einzelne Unterseiten oder Abschnitte direkt aus Google sind damit möglich. Steuerbar ist auch diese Funktion leider nicht, allerdings ist der Einsatz der Vorgaben in schema.org (https://schema.org/) die Grundlage dafür. Die oben bereits genannten Plugins erledigen diese Arbeit und auch für das Inhaltsverzeichnis mit den Sprungmarken gibt es automatische Hilfe. Einfach nach Table of Contents im Bereich Plugins installieren suchen und ein grafisch Passendes auswählen.

Evaluierung nach dem E-A-T-Prinzip

Expertise (Fachkenntnis), Authoritativeness (Autorität), trustworthiness (Vertrauenswürdigkeit). Google möchte seinen Usern im Idealfall vertrauenswürdige Inhalte von ausgewiesenen und vertrauenswürdigen Experten liefern. Betreffend dieser Reputation des Autors gibt es sogar einen eigenen google internen AuthorRank, welchen man aber nirgends einsehen kann.

Folgende Maßnahmen tragen erwiesenermaßen positiv dazu bei, dass eine Seite als vertrauenswürdig und der Autor als Experte eingestuft wird:

- die Seite ist mit SSL verschlüsselt (https:// = Positive User Experience)

- die Seite hat ein vollständiges, reales Impressum mit Kontaktmöglichkeit

- die Seite hat eine Datenschutzerklärung und beachtet die Datenschutzgrundverordnung (DSGVO)

- die Seite besitzt ein ausführliches Über mich / About me / Teamvorstellung

- die einzelnen Beiträge haben eine aussagekräftige Autorenbox samt Kurzvorstellung und Foto

- die Seite zeigt keine oder nur wenige Werbebanner

- die Seite hat keine oder möglichst wenig ausgehende broken links

Letztere sollten mit einem kostenlosen Broken Link Checker Plugin überwacht werden, denn so ein ausgehender Link kann sich immer mal wieder ändern. Auch online gibt es hilfreiche Tools, um die eigene Webseite auf kaputte ausgehende Links zu prüfen, etwa https://www.brokenlinkcheck.com/.

Als externe Merkmale für Vertrauenswürdigkeit und Fachkenntnis eines Autors gelten vor allem auch Links von anderen anerkannten themenrelevanten Webseiten. Eigene Artikel auf anderen Webseiten, etwa von Zeitschriften, Verlagen oder Sendern, sollten daher, wenn möglich, auch einen Backlink auf die eigene Webpräsenz erhalten. Das stärkt den eigentlichen Verfasser als Autorität in seinem Fach.

Duplicate Content und der Canonical Tag

Im Zuge dessen sei erwähnt, dass auch doppelter Content (duplicate content) im Internet unbedingt zu vermeiden ist. Falls ein Artikel mehrfach online auffindbar ist, wäre der Meta Tag Canonical Tag im HTML-Code des Originals sehr wichtig. Damit wird die Original-URL (kanonische URL) des Urhebers festgelegt.

Google Disavow für Bad Links

Nicht jeder Link ist auch ein guter Backlink, es gibt auch negative Links. Diese sollte man möglichst vermeiden, was in der heutigen Zeit leider nicht so ohne weiteres möglich ist. Wer von wo auf eine Seite verlinkt liegt nicht in der Hand des Seiteninhabers, wird aber dennoch gewertet. Mit der Google Search Console kann man im Bereich Links zumindest feststellen welche Domains auf die eigene Webseite verlinken. Sind darunter schwarze Schafe kann man diese entwerten. Zu den unerwünschten Backlinkquellen zählen:

- Webseiten mit Hassreden und Hetze

- Webseiten mit falschen Inhalten und Fakenews

- schädliche Webseiten mit Viren und Malware

- Phishing-Webseiten nur für den Datendiebstahl

- dubiose Sex- und Glücksspielseiten

- SPAM-Links von sinnfrei automatisch erzeugtem Content mit aggressiver Werbung

Hier bietet Google eine Möglichkeit zu Gegenmaßnahmen, indem man diese Links im Index für ungültig erklärt:

Dieses Tool ist mit Bedacht einzusetzen.

Die Dateien robots.txt und sitemap.xml

Die beiden wichtigen Dateien robots.txt und sitemap.xml sagen dem Webcrawler (auch spider, crawling bot, searchbot oder robot genannt) der Suchmaschinen ob und wo sie auf einer Seite den Content finden, crawlen und indexieren dürfen. Darüber kann man selektiv ganze Bereiche einer Webseite für den Suchmaschinenindex sperren oder gezielt unerwünschte Bots ausschließen. Auch diese Dateien werden automatisch über die nützlichen Plugins Yoast SEO oder Rank Math SEO erzeugt.

Inhalte optimieren für die Google Bildersuche

In seiner Universal Search bietet Google eine eigene Suchmaschine für Bilder, welche sehr gerne genutzt wird und viele Besucher auf die Webseite bringen kann. Daher sind auch diese Medien unbedingt im Dateinamen und in den Alt Tags (Alternativer Text / Bild title-Attribut) mit den wichtigsten Keywords zu beschriften.

Aus DSC_0815.jpg wird sonnenuntergang-venedig-italien.jpg.

Dieser Alternative Text hilft also nicht nur sehbehinderten Besuchern eines Blogs sondern auch den Bots. Übertreiben sollte man es aber auch hier nicht, es reichen drei bis fünf beschreibende Worte.

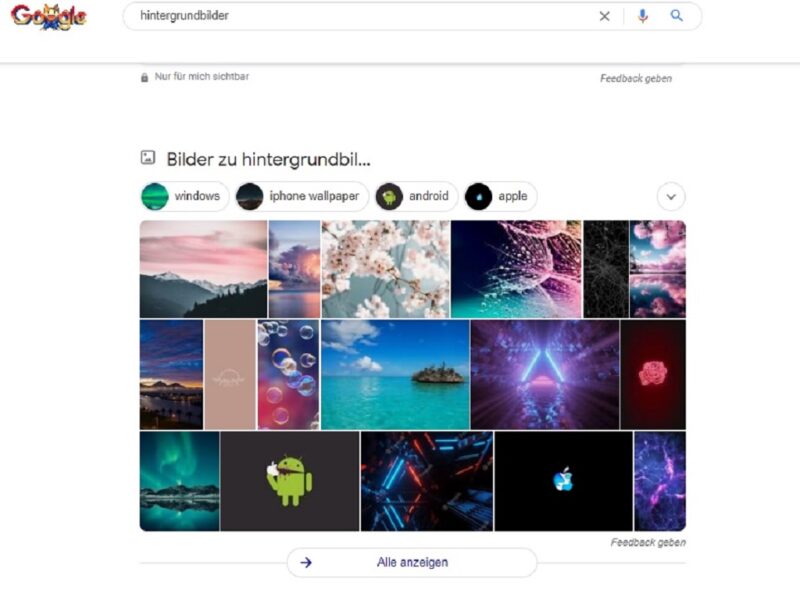

Mit voller Absicht ist dieses Foto des Coconut Rock vor Mauritius seit gut einem Jahr in einer Top-Position bei der Google Bildersuche zum Keyword „Hintergrundbilder“. Gut 280.000 Anfragen entfallen monatlich einzig auf dieses Keyword und es bescherte dem Blogbetreiber gute Zugriffszahlen in einer schweren Zeit. Neben dem tollen Bild waren sicher auch sorgsam recherchierte Keywords und gute Backlinks hilfreich beim Erfolg. Doch gegen die großen Webseiten, die in der normalen Google Suche auftauchen hat man damit wenig Chancen.

Schnelle + mobilfreundliche Webseite = Positive User Experience

Spaß soll der User auf einer Seite haben und eine möglichst positive Nutzererfahrung. Seit Mitte des Jahres ist die (positive) User Experience (UX) ein fester Bestandteil des Google Algorithmus. Das bedeutet als erstes, dass eine Webseite unbedingt responsive und mobilfreundlich sein muss, denn ein Großteil der Suchanfragen kommt bereits seit vielen Jahren über das Smartphone. Dies würdigt Google mit dem Grundsatz mobile first.

In diesem Zusammenhang sollte einem auch klar sein, dass der nicht eingetippte Kontext einer Suchanfrage ebenfalls eine große Rolle spielt. Wo und wann jemand von welchem Endgerät abfragt ist ebenfalls ausschlaggebend für das ausgelieferte Suchergebnis, spätestens bei einer Anfrage vom Handy wie etwa „Wie komme ich am Schnellsten zum Gardasee?“.

Schnell laden soll die Webseite außerdem auch noch, was nicht nur vom Webhosting, sondern auch von der gesamten Programmierung und dem Quellcode eines Themes (Design) abhängig ist. Da ist es manchmal unabdingbar ein veraltetes Template auszutauschen oder man muss sogar seine WordPress-Installation umziehen auf einen anderen Server.

Auch caching (vorladen) und lazy loading (verzögertes Laden von Bildern und Kommentaren beim Scrollen) tragen zu einem optimierten Seitenaufbau und damit zur Geschwindigkeit einer Seite bei. Ebenso sieht Google das selbst entwickelte Bildformat mit der Endung .webp (https://de.wikipedia.org/wiki/WebP) gerne. All dies trägt zur gewünschten Nutzerfreundlichkeit bei und sorgt für jede Menge Aufwand seitens der Webmaster.

Eine Ladezeit von unter eineinhalb Sekunden wäre das anstrebenswerte Ziel. Wie schnell eine Webseite lädt lässt sich hier testen: https://tools.pingdom.com/ (Bitte den Server in Frankfurt auswählen um vergleichbare Daten zu erhalten.)

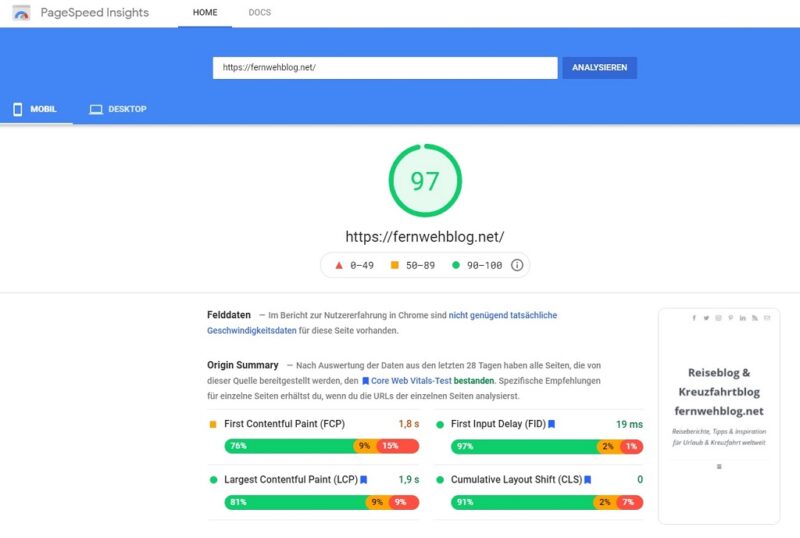

Wie gut oder schlecht Google das bewertet kann man hier selbst testen:

In diesem guten Ergebnis stecken jede Menge Geld, Zeit und Arbeit. Unter anderem halfen ein neuer Webhoster, ein komplett neues Design und ein paar kostenpflichtige Plugins zum guten Ergebnis. Wer sich so etwas nicht selbst zutraut kann sich vom Blog-Helfer Thomas Jansen https://www.blog-helfer.de/ unter die Arme greifen lassen. Dann klappt das auch relativ ausfallsfrei.

Hat man den Core Web Vitals-Test erst einmal bestanden, gibt das ein zusätzliches positives Rankingsignal an Google. Zur Verbesserung der Ladezeiten können folgende kostenlose WordPress-Plugins beitragen:

- Autoptimize https://de.wordpress.org/plugins/autoptimize/ in Verbindung mit

- Async JavaScript https://de.wordpress.org/plugins/async-javascript/

- EWWW Image Optimizer https://de.wordpress.org/plugins/ewww-image-optimizer/

- WP Fastest Cache https://de.wordpress.org/plugins/wp-fastest-cache/ und / oder

- WP-Optimize https://de.wordpress.org/plugins/wp-optimize/

Diese kostenpflichtigen WordPress-Plugins liefern noch bessere Ergebnisse:

- ShortPixel Image Optimizer (https://wordpress.org/plugins/shortpixel-image-optimiser/)

- WP Rocket (https://wp-rocket.me/)

ShortPixel wandelt sogar selbstständig die bereits vorhandenen Bilder in das optimierte .webp-Format um.

Achtung: Die detaillierten Einstellungen abseits der Voreinstellungen sollte ein Webmaster oder Administrator vornehmen, der ein wenig Ahnung von Webdesign hat.

Backlinks von anderen Webseiten und Blogs

Ein guter Backlink sollte Dich überraschen! Doch leider wartet man oft vergebens darauf, wenn man nicht selbst in der Branche tätig ist und über die nötigen Kontakte verfügt. Wie oben bereits erwähnt tragen gute Backlinks entscheidend zur Reputation einer Webseite im Netz bei.

Diese Links sollten im Quelltext jedoch nicht die zusätzlichen Attribute nofollow, sponsored (bezahlt) oder ugc (user generated content) haben, denn dann werden sie nicht wirklich gewertet. Bei Beiträgen aus Foren oder Blogkommentaren passiert das gerne. Früher war das mal ein beliebtes Hilfsmittel in Sachen SEO, doch es wurde zu viel Schindluder damit getrieben. Diese Kommentarlinks und Links aus Forenbeiträgen bringen vielleicht etwas direkten Traffic auf die Seite, jedoch dauerhaft keine Verbesserung im Ranking. Einzige Ausnahme ist ein nofollow-Link von WikiPedia, entsprechend schwer sind diese auch zu bekommen. Die Tags noopener und noreferer spielen übrigens keine Rolle.

Zu erkennen ist die betreffende Linksart nur im Quelltext einer Webseite. Dazu einfach auf der betreffenden Seite die rechte Maustaste drücken und Seitenquelltext anzeigen auswählen. Hier muss man dann die Suchfunktion nutzen und die eigene URL suchen.

So sieht der nofollow-Link im HTML-Quelltext aus:

<a href=“https://www.vdrj.de/“ rel=”nofollow“>VDRJ</a>

So hingegen sieht der DoFollow-Link im HTML-Quelltext aus:

<a href=“https://www.vdrj.de/„>VDRJ</a>

Ein themenrelevanter DoFollow-Backlink mit einem passenden Anchor Text (Ankertext / Linktext) von einer anerkannten Seite ist der angestrebte Idealfall. Dieser Link hat keine entwertenden Attribute im Quelltext und gibt seine Linkpower (Linkjuice) ungebremst weiter. Eine bessere Bewertung durch Google ist der Lohn dafür. Einstellen kann man diese Attribute in der Regel bereits bei der Verlinkung aus dem Text im Editor des jeweils genutzten CMS (Content Management System).

Augen auf, auch hier lauern Fallen für den Laien: Über einen weiteren Code in den Meta Tags kann man mit einem Schlag die Links einer ganzen für SEO Seite entwerten:

<meta name=”robots” content=”nofollow” />

Jetzt könnte man auf die Idee kommen den großen Linktausch mit Gott und der Welt zu starten oder gar den gezielten Backlinkkauf. Doch so etwas mag Google gar nicht und straft jeden den man dabei erwischt mit dem gefürchteten Google Penalty ab. (Siehe auch Manuelle Maßnahmen in der Google Search Console) https://developers.google.com/search/docs/advanced/guidelines/link-schemes?hl=de

Man ist also besser auf der Hut vor dieser beliebten Art der Offline-Optimierung, das haben bereits andere versucht. Aus der sog. Sandbox wieder heraus zukommen dauert Monate und braucht viel Schriftverkehr mit Google. Wobei die nur selten antworten, im Zweifel erst auf ein Anwaltsschreiben.

Hier fünf kostenlose und wirklich gute Backlinkquellen:

Wer sich generell etwas sichtbarer im Netz machen möchte findet in den folgenden beiden Blogbeiträgen zahlreiche Möglichkeiten für hochwertige und hilfreiche DoFollow-Backlinks:

https://fernwehblog.net/seo-linkaufbau-kostenlos-backlinks-blogger/

https://fernwehblog.net/backlinks-landing-page-social-bookmarking/

Themenrelevante Links für die eigenen Beiträge sind oft nur schwer zu bekommen. Einblicke wie die Konkurrenz das macht erhält man über kostenpflichtige Tools wie ahrefs. Ein paar gute kostenlose Ideen zum Thema Linkaufbau warten hier: https://ahrefs.com/blog/de/linkaufbau/

Nicht vergessen: Die interne Verlinkung

Das Thema Linkpower hat man übrigens selbst ein wenig in der Hand, denn auch die interne DoFollow-Verlinkung von Beiträgen mit den dazugehörigen Ankertext bringt einen ein gutes Stückchen weiter nach vorne. Wo es gut passt sollte man hemmungslos die Blogbeiträge untereinander verlinken und Google damit zeigen, was einem wichtig ist.

Die nachträgliche Suchmaschinenoptimierung

Für eine einfache Webseite mit nur einem bestimmenden Thema ist die nachträgliche Seitenoptimierung relativ einfach umzusetzen. Das Optimieren eines komplexen Blogs mit all den unterschiedlichen Artikeln und Themen hingegen ist sehr viel anspruchsvoller und zeitaufwändiger. Hier muss tatsächlich jeder einzelne Blogbeitrag analysiert und individuell überarbeitet werden.

Wer jetzt sogar an ein komplettes Re-Design mit neuer Seitenarchitektur samt möglichst flacher Menüstruktur denkt, der sei gewarnt: Hier kann man erst einmal ziemlich abstürzen bevor es nach einigen Monaten nachhaltig besser wird.

Extrem wichtig ist hier vor allem die Weiterleitung jeder alten URL auf die neue URL mit dem HTTP Response status code 301 für moved permanently (dauerhaft umgezogen). Das ist wie der umzugsbedingte Nachsendeauftrag bei der Post. Jeder kennt schließlich den Status Code 404 – Seite nicht gefunden (broken Link) aus eigener Erfahrung und diese negative User Experience möchte Google dem Nutzer ersparen. Plugins wie Rank Math SEO erledigen diese permanente Weiterleitung sogar schon automatisch bei der Änderung der URL.

Keine Angst vor der auf den ersten Blick unüberwindbar groß erscheinenden Aufgabe – SEO wirkt!

Drei abschließende hilfreiche SEO-Tipps

- Halte die Startseite möglichst frei von externen Verlinkungen wie etwa der allseits beliebten Blogroll. Ausgewählte ausgehende Links zu den eigenen Social Media Kanälen sind hingegen in Ordnung. Auf den Unterseiten und in den Blogbeiträgen kann man sich dann nach Lust und Laune austoben. Jedoch sollten es pro Seite nicht mehr als 100 ausgehende Links sein, da man sonst als ziemlich sicher SPAM-Seite eingestuft wird.

- Ausgewählte fettgedruckte Keywords in den Blogbeiträgen, so wie in diesem hier, tragen ebenfalls ein Stück zum guten Ranking bei. Damit werden Google wichtige Inhalte signalisiert.

- Kein Verlass ist auf vermeintlich starke Backlinks von selbst erstellten Profilseiten, Einträgen in kostenlosen Webkatalogen oder Forenbeiträgen.Google erkennt diese schnell als solche und gibt ihnen auch den passenden geringeren Stellenwert. Lieber ein themenrelevanter Backlink von einem anerkannten Medium als zehn solcher Links.

Wie schnell wirken die SEO-Maßnahmen?

Viel Geduld und Durchhaltevermögen sind hier gefragt. Schnelle Änderungen im Title und der Description bereits bestehender Beiträge können schon innerhalb weniger Tage eine sichtbare Verbesserung der Auffindbarkeit bewirken. Doch in der Regel greifen all diese SEO-Maßnahmen frühestens nach vier bis zwölf Monaten dauerhaft.

Am Ball bleiben und sich immer wieder über die wichtigsten Neuerungen informieren ist dringend erforderlich. Oft sind es nur kleine Änderungen, die dann schnell sichtbare Auswirkungen zeigen und einen Beitrag von denen der Konkurrenz abheben lassen. Der Lohn dafür sind stetig steigende Besucherzahlen, so Google es will.

Anmerkung des Autors: Dieser Artikel enthält, trotz seiner Länge, bei weitem nicht alles was SEO in der heutigen Zeit ausmacht – das würde schlichtweg den Rahmen sprengen. Trotz seiner absichtlich extrem suchmaschinenkonformen Schreibweise wird er auch nicht in zwei Wochen in den Google Top Ten zum Thema SEO erscheinen. Das wäre vergebliche Liebesmüh bei der riesigen Konkurrenz durch Profis im Internet. Zwar trage ich mittlerweile die Auszeichnung SEO Professional, jedoch stehe ich noch ganz am Anfang eines harten und steinigen Weges bergauf.

Wow, vielen Dank für diesen umfangreichen Artikel. Da war viel Neues dabei und ich freue mich schon die Impulse und Anregungen demnächst umzusetzen.

Was man alles beachten muss, um bei Google überhaupt einmal aufzutauchen, ist schon enorm viel. Wer hat denn so viel Zeit, wenn man auch Blog-Beiträge schreiben muss?

@Judex: Das Problem ist halt, dass Google & Co einem da Wahl lassen. Will man in den Suchergebnissen weit oben auftauchen, führt an SEO kein Weg vorbei.